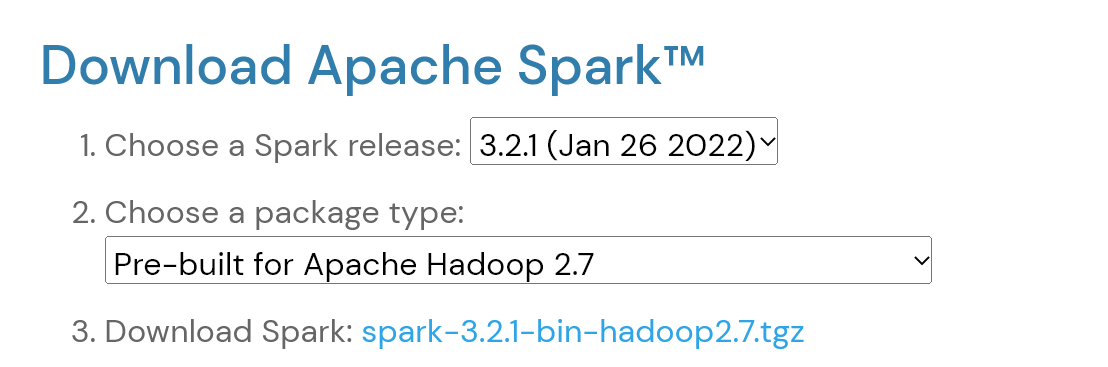

https://spark.apache.org/downloads.html 에서

아파치 하둡 2.7과 함께 사용할 수 있는 스파크 버전을 확인한다.

!apt-get install openjdk-8-jdk-headless -qq > /dev/null

!wget -q https://downloads.apache.org/spark/spark-3.2.1/spark-3.2.1-bin-hadoop2.7.tgz

!tar -xvf spark-3.2.1-bin-hadoop2.7.tgz

!pip install -q findspark

!pip install pyspark만약 버전이 다르다면 위 코드에서 버전을 변경하면 된다.

import os

os.environ["JAVA_HOME"] = "/usr/lib/jvm/java-8-openjdk-amd64"

os.environ["SPARK_HOME"] = "/content/spark-3.2.1-bin-hadoop2.7"

from pyspark.sql import SparkSession

spark = SparkSession.builder.master("local[*]").getOrCreate()df = spark.read.format("csv")\

.option("header", "true")\

.option("inferSchema", "true")\

.load("data/retail-data/by-day/2010-12-01.csv")

df.printSchema()

df.createOrReplaceTempView("dfTable")

root

|-- InvoiceNo: string (nullable = true)

|-- StockCode: string (nullable = true)

|-- Description: string (nullable = true)

|-- Quantity: integer (nullable = true)

|-- InvoiceDate: string (nullable = true)

|-- UnitPrice: double (nullable = true)

|-- CustomerID: double (nullable = true)

|-- Country: string (nullable = true)

간단히 코랩에서 파이스파크를 사용할 수 있다.

'인프라,데이터 > Spark' 카테고리의 다른 글

| 스파크 완벽 가이드 Part 2 : 구조적 API (1) (0) | 2022.02.26 |

|---|---|

| 스파크 완벽 가이드 Part 1 : 빅데이터와 스파크 간단히 살펴보기 (0) | 2022.02.19 |